- Настроить файл Robots.txt в Magento 2

- Пользовательские инструкции для Magento 2 Robots.txt

- Разрешить полный доступ

- Запретить доступ ко всем папкам

- Инструкции по умолчанию

- Ограничить учетную запись пользователя и страницы оформления заказа

- Запретить страницы поиска по каталогу

- Запретить поиск фильтра URL

- Ограничить каталоги CMS

- Запретить дублирующийся контент

- Заключение

- Файяз Хаттак

- Удвойте количество конверсий с помощью Magento Managed Cloud

Время чтения: 4 минуты

Одной из наиболее важных частей оптимизации сайта является настройка файла robots.txt в веб-приложении. Если вы разрешаете поисковым системам индексировать ваш веб-сайт, необходимо также указать сканерам, чтобы они не индексировали в основном запрещенные страницы через файл robots.txt.

По умолчанию конфигурация Magento 2 включает настройки для генерации и управления инструкциями для веб-сканеров и ботов, которые индексируют ваш магазин. Эти инструкции сохраняются в файле robots.txt Magento 2, который находится в корне Каталог установки Magento 2. Эти директивы признаются большинством поисковых систем, чтобы избежать индексации определенных страниц вашего интернет-магазина Magento 2, которые используются системой внутри системы. Вы можете использовать стандартные настройки Magento 2 или определить свои собственные инструкции для роботов поисковых систем.

В этой статье я покажу вам, как настроить файл robots.txt в Magento 2. Я предполагаю, что у вас уже установлен Magento 2 на вашем сервере веб-хостинга. Если не, подписаться на Cloudways прямо сейчас и запустите магазин Magento 2 с удобной функцией установки приложения в один клик.

Настроить файл Robots.txt в Magento 2

1. Прежде всего, войдите в вашу панель администрирования Magento 2 .

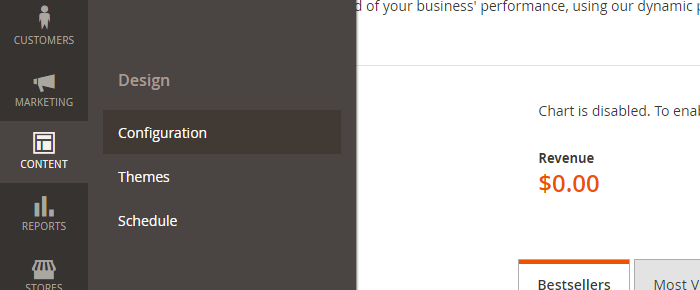

2. Нажмите « Содержимое» и в разделе « Дизайн» выберите « Конфигурация» .

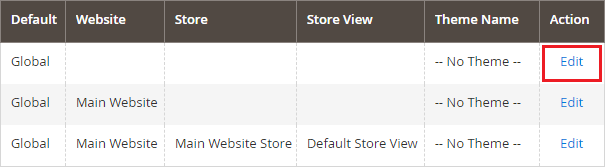

3. С левой стороны отредактируйте глобальную конфигурацию проекта .

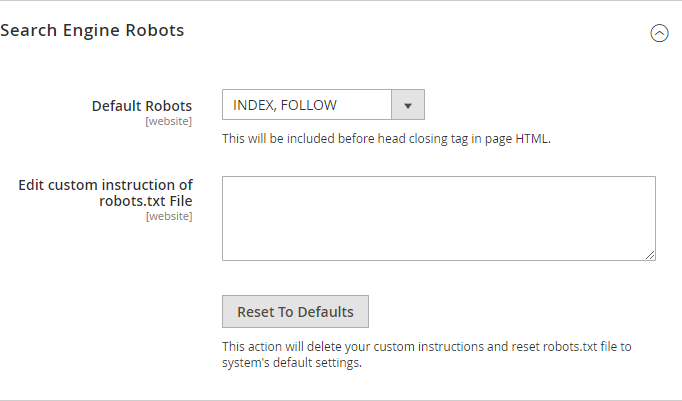

4. Разверните раздел « Роботы для поисковых систем ».

5. Теперь вам нужно сделать следующее:

a) Установите опцию Роботы по умолчанию на одно из следующих:

INDEX, FOLLOW: поручает поисковым системам индексировать магазин и позже проверять наличие изменений.

NOINDEX, FOLLOW: поручает сканерам поисковых систем избегать индексации магазина, но позже проверьте наличие изменений.

INDEX, NOFOLLOW: поручает поисковым системам индексировать магазин один раз, но не проверять наличие изменений.

NOINDEX, NOFOLLOW: поручает сканерам поисковых систем избегать индексации магазина и не проверять наличие изменений.

б) В опции « Редактировать пользовательскую инструкцию файла Robots.txt» вы можете при необходимости ввести пользовательские инструкции. Например, при разработке вашего интернет-магазина Magento 2 вы можете запретить доступ ко всем папкам, вводя пользовательские инструкции.

c) Кнопка « Сбросить по умолчанию» удалит ваши пользовательские инструкции и сбросит файл roents.txt Magento 2 к настройкам системы по умолчанию.

6. По завершении настройки нажмите кнопку « Сохранить конфигурацию» , чтобы применить изменения.

Пользовательские инструкции для Magento 2 Robots.txt

Как и любое другое веб-приложение или платформу электронной коммерции, вы можете добавить пользовательские инструкции в файл robots.txt в Magento 2. Вот несколько примеров «Disallow», которые следует учитывать для файла Robots.txt Magento 2.

Разрешить полный доступ

Пользователь-агент: * Disallow:

Запретить доступ ко всем папкам

Пользователь-агент: * Disallow: /

Инструкции по умолчанию

Disallow: / lib / Disallow: /*.php$ Disallow: / pkginfo / Disallow: / report / Disallow: / var / Disallow: / каталог / Disallow: / customer / Disallow: / sendfriend / Disallow: / обзор / Disallow: / * SID =

Ограничить учетную запись пользователя и страницы оформления заказа

Disallow: / checkout / Disallow: / onestepcheckout / Disallow: / customer / Disallow: / customer / account / Disallow: / customer / account / login /

Запретить страницы поиска по каталогу

Disallow: / catalogsearch / Disallow: / catalog / product_compare / Disallow: / каталог / категория / просмотр / Disallow: / каталог / продукт / просмотр /

Запретить поиск фильтра URL

Disallow: / *? Dir * Disallow: / *? Dir = desc Disallow: / *? Dir = asc Disallow: / *? Limit = all Disallow: / *? Mode *

Ограничить каталоги CMS

Disallow: / app / Disallow: / bin / Disallow: / dev / Disallow: / lib / Disallow: / phpserver / Disallow: / pub /

Запретить дублирующийся контент

Disallow: / тег / Disallow: / обзор /

Заключение

Стандарт исключения роботов, также известный как файл robots.txt, важен для вашего магазина электронной коммерции Magento 2 при общении с веб-сканерами. Этот стандарт определяет, как информировать поисковых роботов о страницах вашего магазина Magento 2, которые следует исключить или открыть для сканирования. Вот почему файл robots.txt важен для правильной индексации магазина Magento 2 и его общей видимости поиска.

Так как Magento 2 предоставляет механизм для создания файла robots.txt, нет необходимости создавать его вручную. Все, что вам нужно сделать, это добавить некоторую конфигурацию в сам Magento 2, и периодически будет генерироваться robots.txt.

Я надеюсь, что вы нашли это краткое руководство по настройке файла Robots.txt в Magento 2 полезным. Теперь успешно добавьте пользовательские инструкции в файл robots.txt, чтобы повысить свой рейтинг в поисковой выдаче.

Если у вас есть какие-либо вопросы, не стесняйтесь поделиться ими в комментариях ниже.

Файяз Хаттак

Файяз - менеджер сообщества Magento в Cloudways - Управляемый Magento Хостинг Платформа. Его цель - узнать и рассказать о PHP и Magento Development в сообществе. Файяз - гурман и любит водить. Вы можете написать ему на [email protected]

Удвойте количество конверсий с помощью Magento Managed Cloud

Бесплатный SSL, бесплатная миграция, оптимизированный стек, встроенный Varnished Cache и многое другое.

Dir * Disallow: / *?Dir = desc Disallow: / *?

Dir = asc Disallow: / *?

Limit = all Disallow: / *?